一、安装显卡驱动与CUDA 程序

1、显卡驱动安装

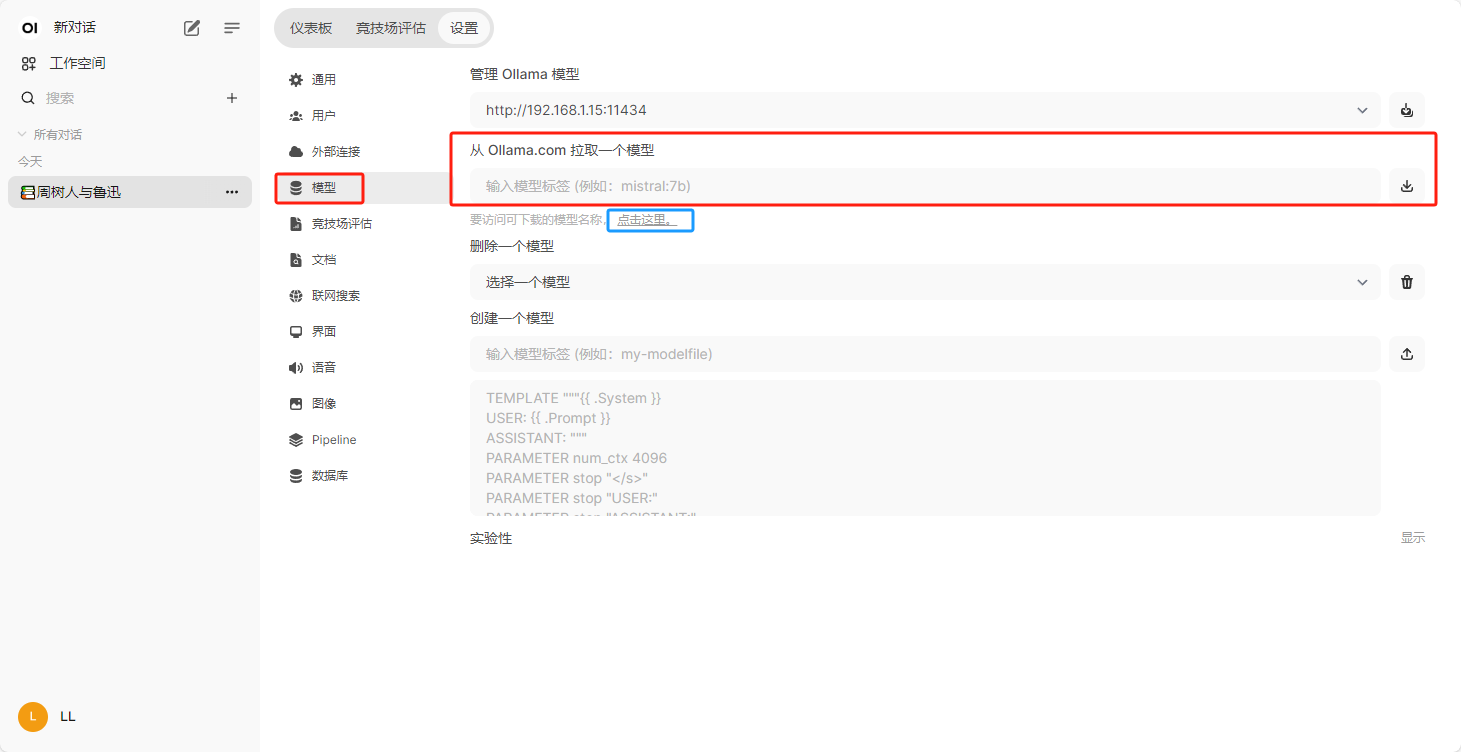

显卡驱动根据自己显卡的型号到官网下载安装即可,或者使用360驱动大师等工具安装显卡驱动。安装完成后你可以在任务管理器的性能选项卡中看到自己的显卡型号以及使用情况。

2、CUDA下载安装

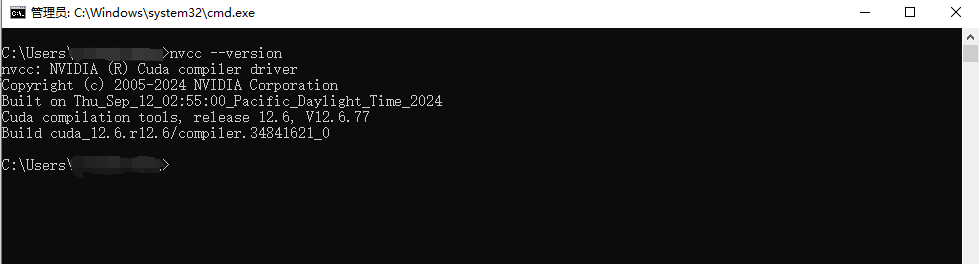

在CUDA官网下载安装,安装完成后可以在在命令提示符窗口中,输入: nvcc --version 如果显示版本号,说明安装成功。

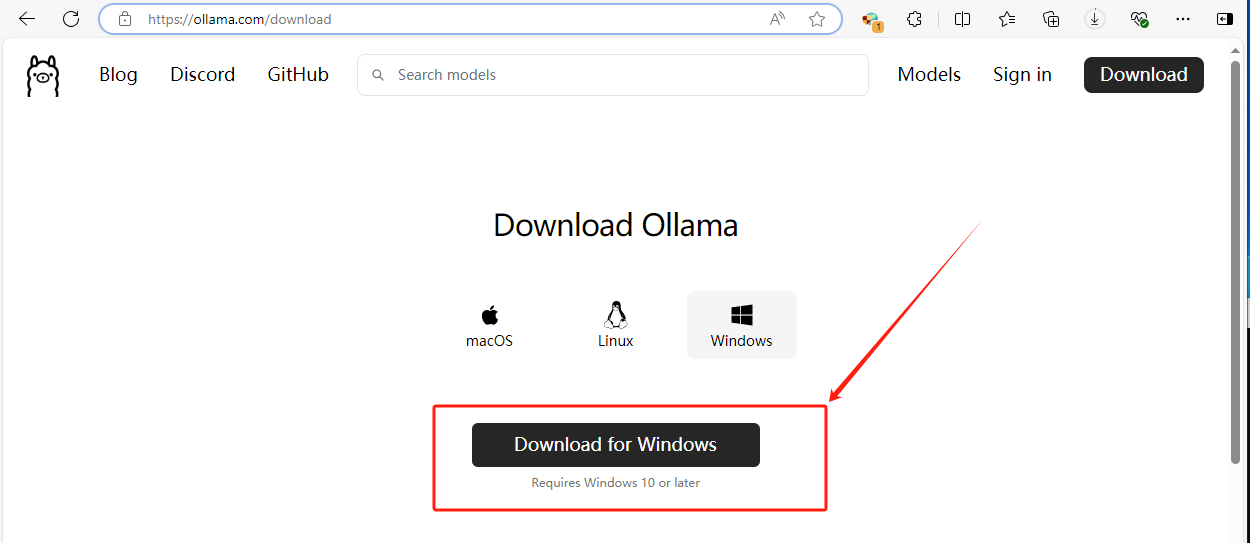

二、安装 Ollama

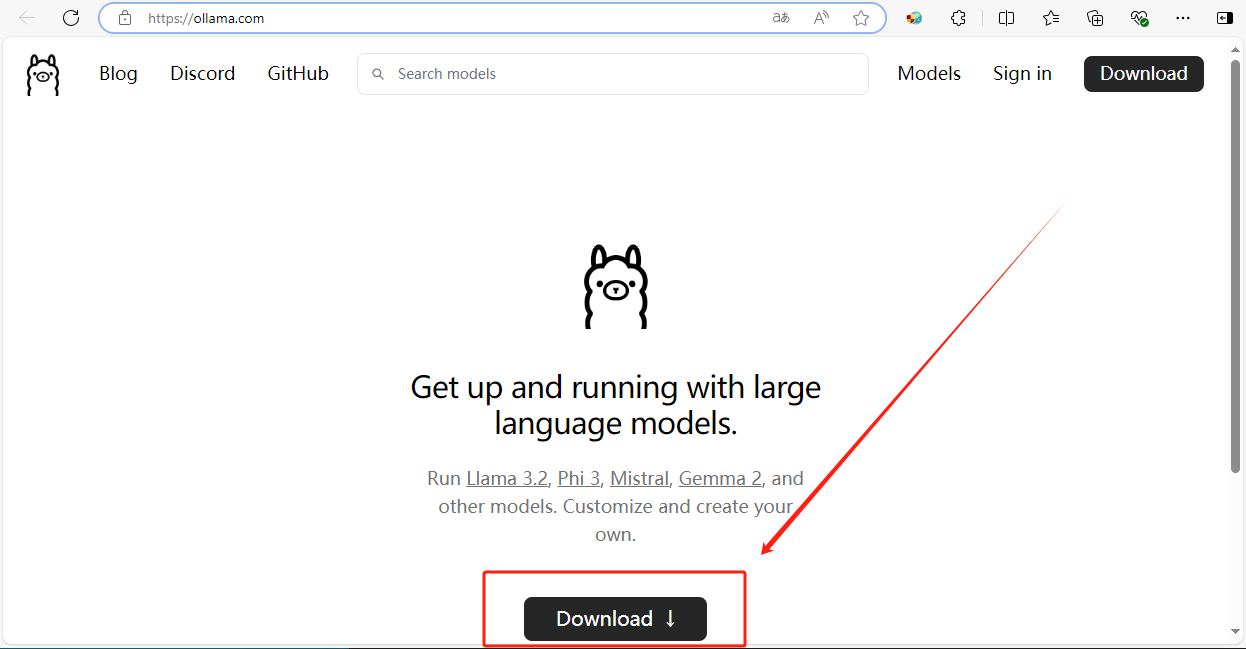

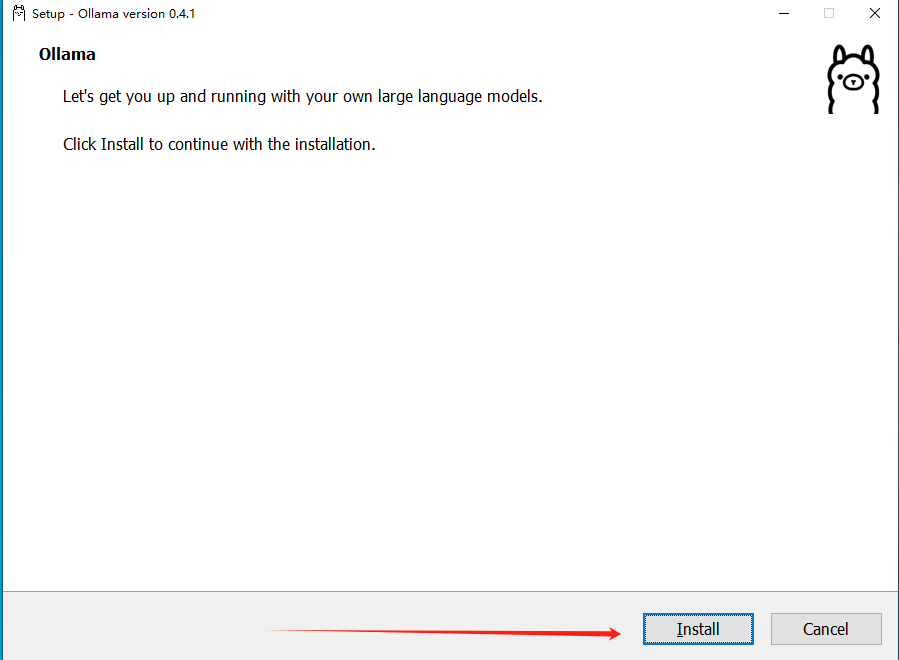

1、从官网下载Ollama安装程序,直接双击安装。

(如果自定义安装位置,需要在命令提示符窗口中使用 OllamaSetup.exe /DIR="d:\some\location" 进行指定安装位置)

在命令提示符窗口中,输入: ollama --version 如果显示版本号,说明安装成功。

2、设置Ollama使用参数

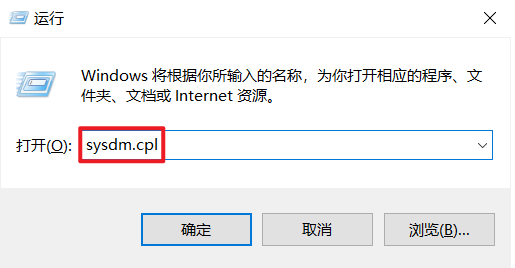

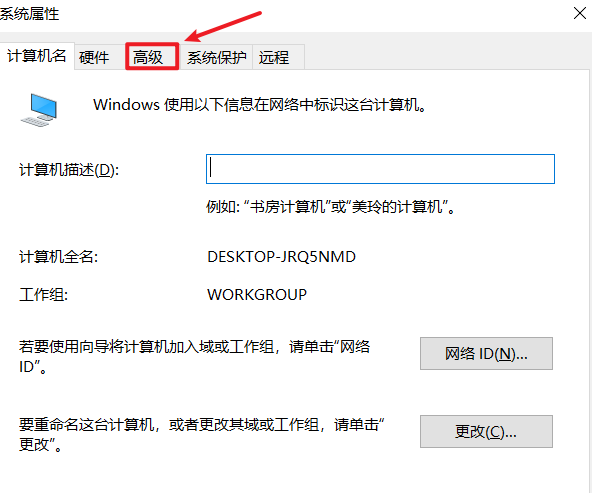

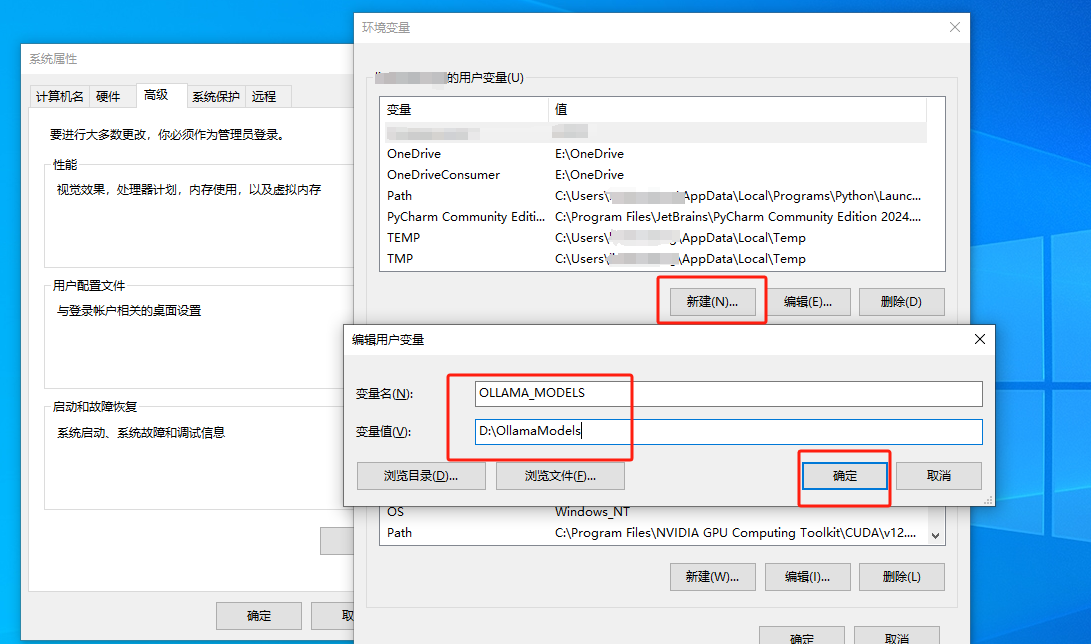

设置使用参数可以让你更灵活的使用Ollama,根据实际需求进行个性化设置,这里推荐设置 OLLAMA_MODELS 和 OLLAMA_HOST 这两个参数,以 OLLAMA_MODELS 为例:

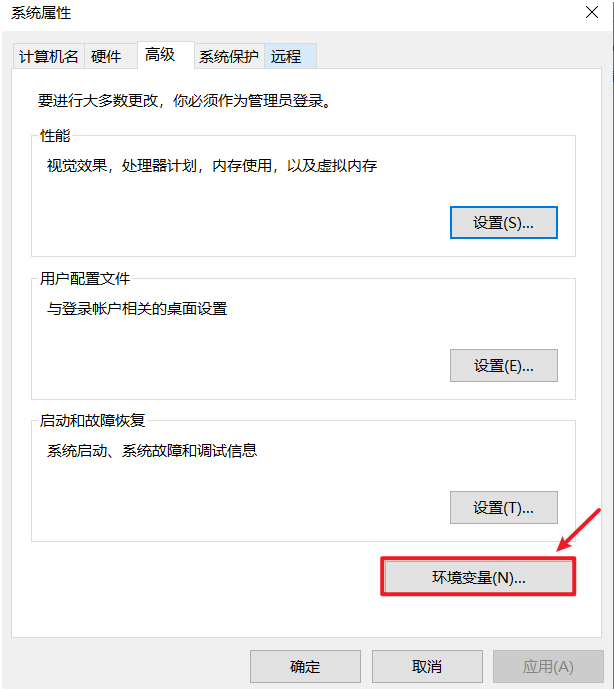

- 按下

Win + R组合键,打开“运行”对话框。 - 输入

sysdm.cpl(这是“System Data Manager”(系统数据管理器)控制面板项的简写),然后按回车键。 - 在打开的“系统属性”对话框中,点击“高级”选项卡,然后在下方点击“环境变量”按钮。这将直接打开环境变量设置界面。

设置完参数后,从右下角系统托盘退出然后重新启动一下Ollama

Ollama常用参数

- OLLAMA_MODELS:模型文件存放目录,默认目录为当前用户目录(Windows 目录:C:\Users%username%.ollama\models,MacOS 目录:~/.ollama/models,Linux 目录:/usr/share/ollama/.ollama/models),如果是 Windows 系统建议修改(如:D:\OllamaModels),避免 C 盘空间不足

- OLLAMA_HOST:Ollama 服务监听的网络地址,默认为127.0.0.1,如果允许其他电脑访问 Ollama(如:局域网中的其他电脑),建议设置成0.0.0.0,从而允许其他网络访问

- OLLAMA_PORT:Ollama 服务监听的默认端口,默认为11434,如果端口有冲突,可以修改设置成其他端口(如:8080等)

- OLLAMA_ORIGINS:HTTP 客户端请求来源,半角逗号分隔列表,若本地使用无严格要求,可以设置成星号,代表不受限制

- OLLAMA_KEEP_ALIVE:大模型加载到内存中后的存活时间,默认为5m即 5 分钟(如:纯数字如 300 代表 300 秒,0 代表处理请求响应后立即卸载模型,任何负数则表示一直存活);我们可设置成24h,即模型在内存中保持 24 小时,提高访问速度

- OLLAMA_NUM_PARALLEL:请求处理并发数量,默认为1,即单并发串行处理请求,可根据实际情况进行调整

- OLLAMA_MAX_QUEUE:请求队列长度,默认值为512,可以根据情况设置,超过队列长度请求被抛弃

- OLLAMA_DEBUG:输出 Debug 日志标识,应用研发阶段可以设置成1,即输出详细日志信息,便于排查问题

- OLLAMA_MAX_LOADED_MODELS:最多同时加载到内存中模型的数量,默认为1,即只能有 1 个模型在内存中

三、下载模型并使用

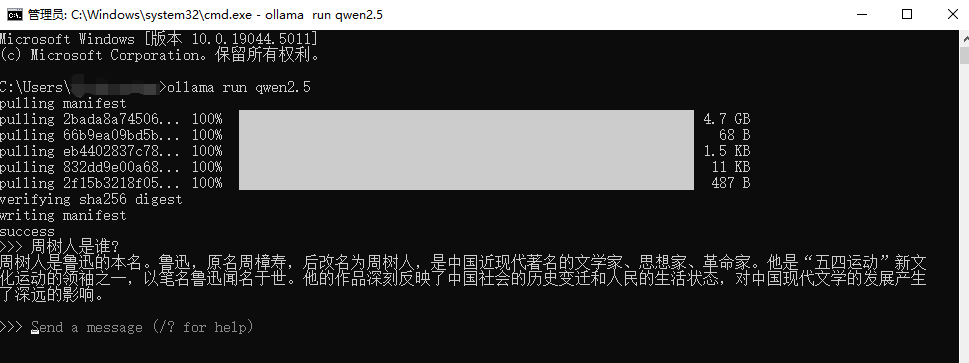

1、下载并运行模型

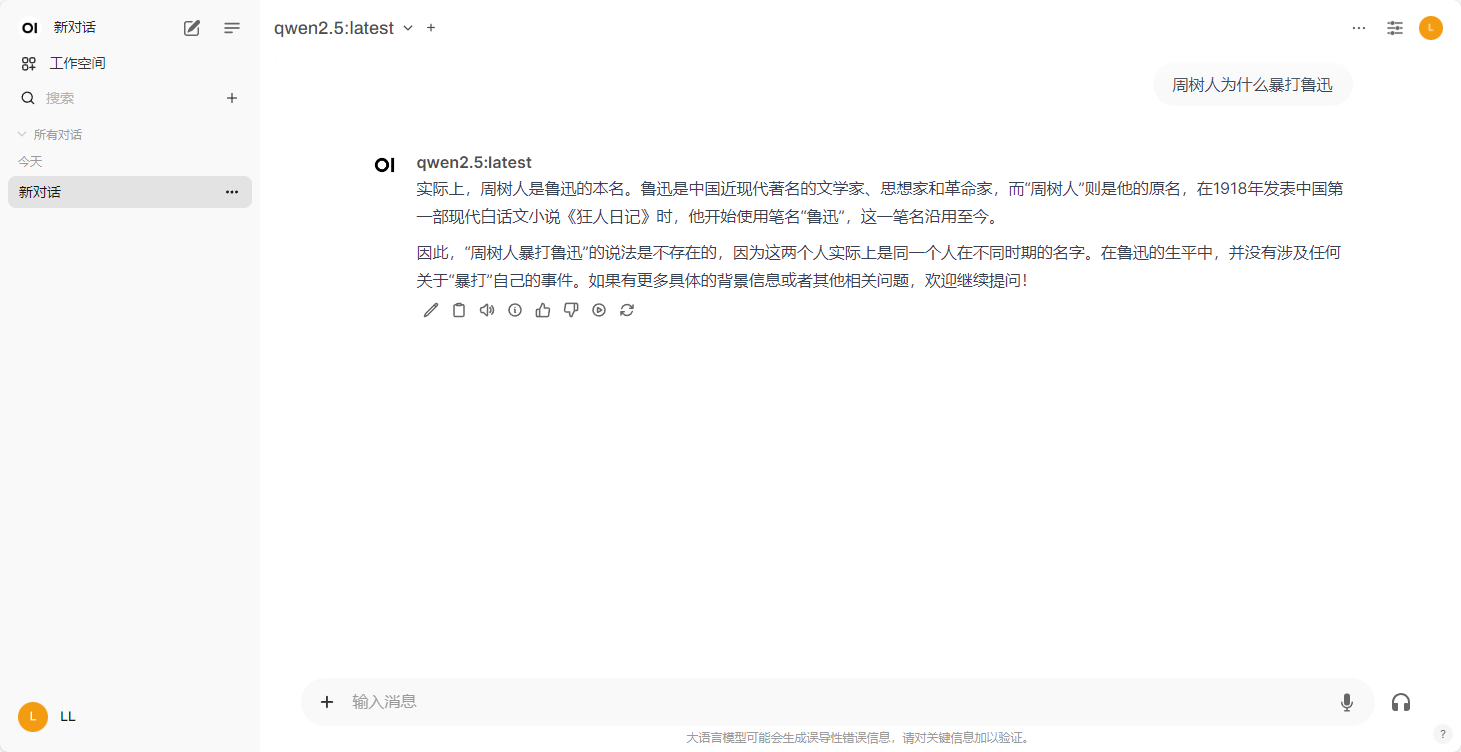

在命令提示符窗口中运行命令 ollama run qwen2.5 ,下载并运行qwen2.5模型,加载好文本模型后,就可以直接在命令行里输入文字开始与模型「对话」

ollama 模型库,可以在这里查找ollama支持的模型

2、使用Ollama API访问模型

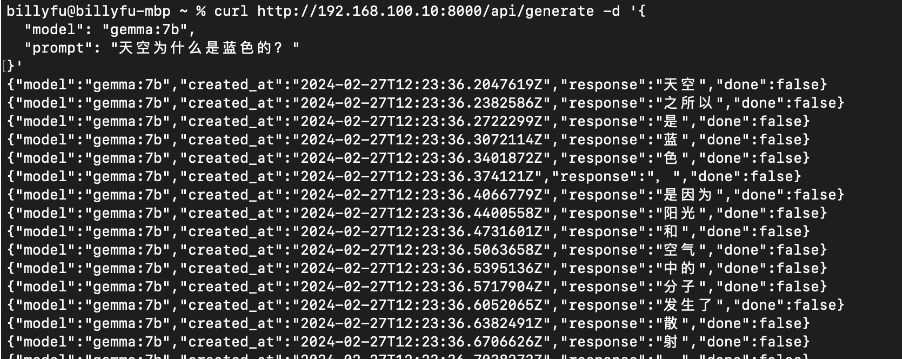

我们不可能只通过命令行来使用,使用Ollama API 把 AI 的功能整合到自己的软件里,或者在NextChat 这类的前端工具中进行调用。

默认地址和端口:Ollama API 的默认地址是http://localhost:11434,可以在安装 Ollama 的系统中直接调用。

如果要修改端口,请参考前面的环境变量配置。

请求示例:

curl http://192.168.100.10:8000/api/generate -d '{

"model": "gemma:7b",

"prompt": "天空为什么是蓝色的?"

}'

四、推荐 Open WebUI

Open-WebUI 是一个基于 Docker 部署的 Web 用户界面,使用户能够在本地环境中轻松运行和管理语言模型。与直接使用命令行工具相比,Open-WebUI 提供了更直观、便捷的交互体验,尤其适合希望进行图形化操作的用户。

1、使用docker安装Open WebUI

这里不再赘述docker的安装,请自行百度。

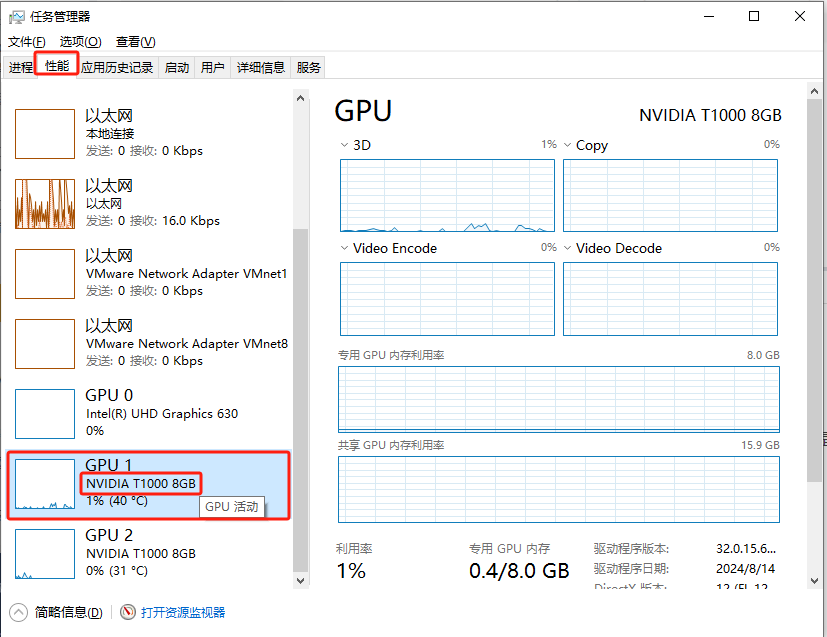

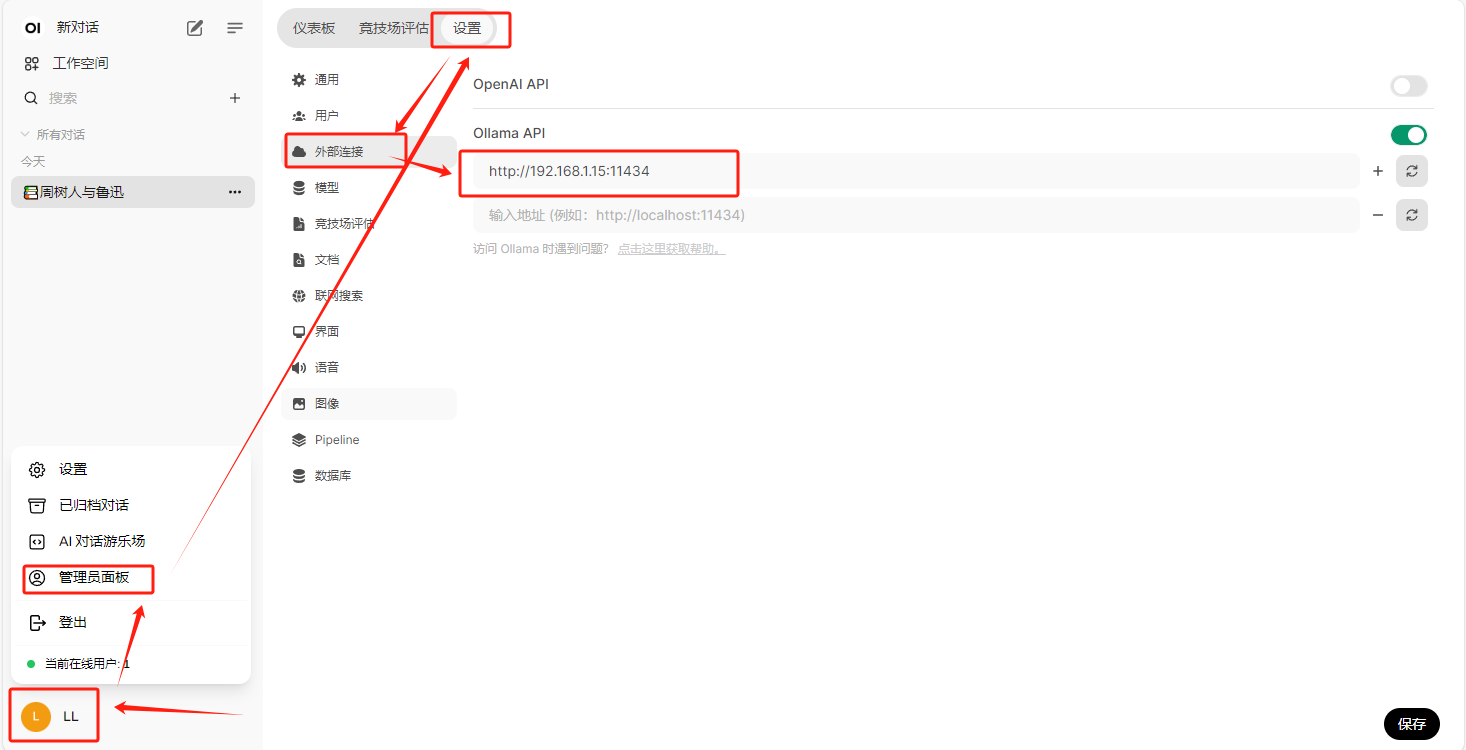

2、Open WebUI的配置使用

Open-WebUI安装完成后,在浏览器中打开 http://localhost:3000 将看到主界面。

首次访问可能需要注册一个账号,注册过程简单易行。

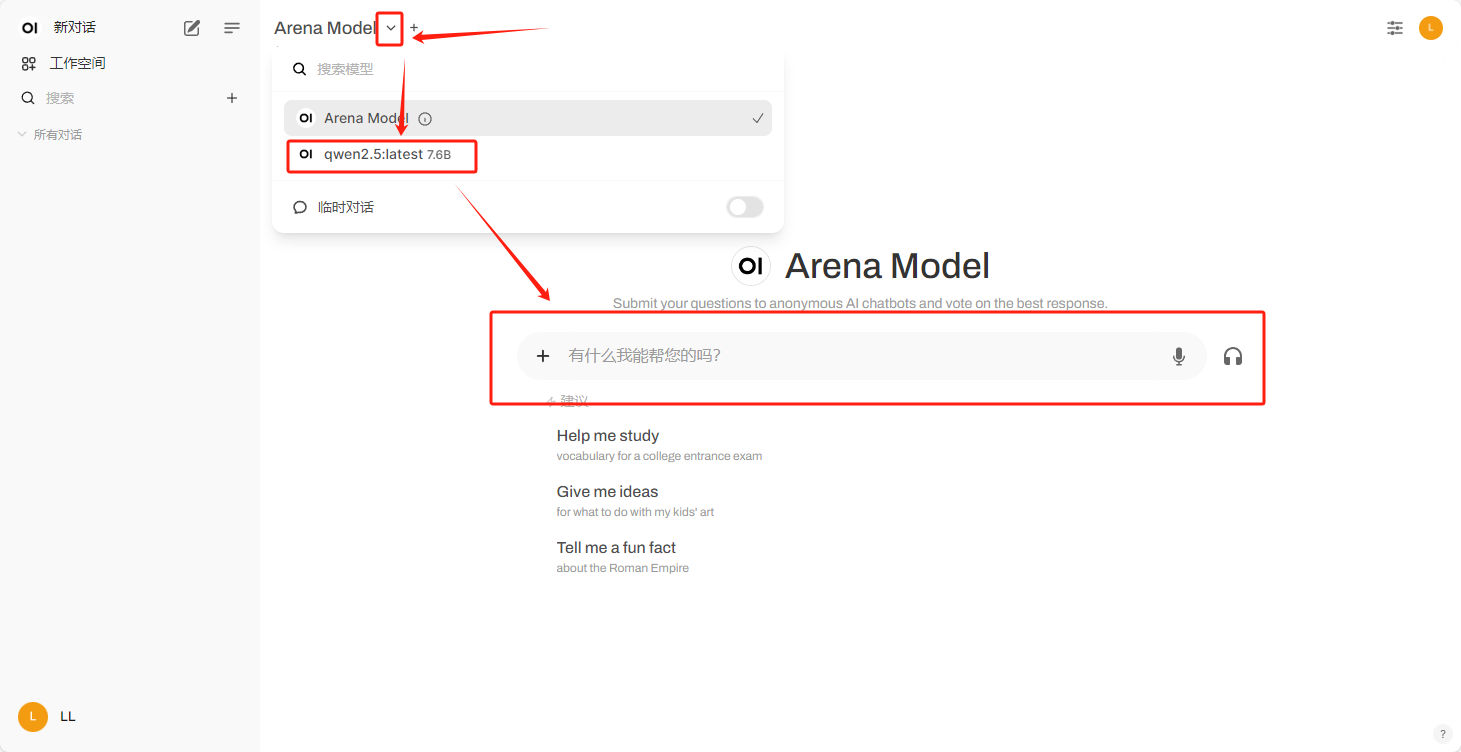

在Open-WebUI中配置Ollama API,实现通过网页对Ollama上的模型的管理和对话

通过Open-WebUI进行模型管理